파라미터 1조 개 이상, 모델 규모 대폭 확장

알리바바그룹이 최신 추론 모델 큐원3-맥스-씽킹(Qwen3-Max-Thinking)을 공개했다.

알리바바그룹은 큐원 챗(Qwen Chat)을 통해 큐원3-맥스-씽킹을 제공하고 모델 API는 알리바바의 생성형 AI 개발 플랫폼 모델 스튜디오(Model Studio)에서 이용할 수 있다고 28일 밝혔다.

이번 최신 추론 모델은 강화학습(Reinforcement Learning)을 위해 1조 개 이상의 파라미터로 모델 규모를 대폭 확장했으며 이를 통해 사실적 지식 처리, 복합 추론, 지시 수행, 인간 선호도 정렬, 에이전트 기능 등 여러 핵심 영역에서 성능 향상을 달성했다.

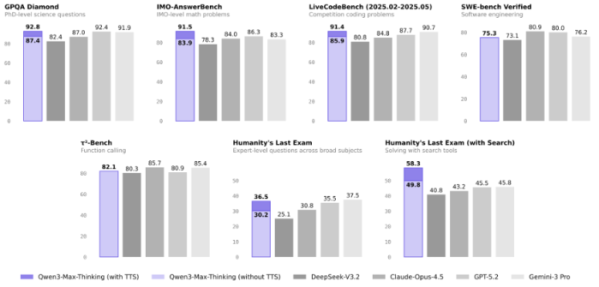

알리바바에 따르면 큐원3-맥스-씽킹은 총 19개 주요 벤치마크 평가에서 클로드 오퍼스 4.5(Claude Opus 4.5), 제미나이 3프로(Gemini 3 Pro), 지피티-5.2-씽킹-엑스하이(GPT-5.2-Thinking-xhigh) 등 최신 고성능 모델들과 비교해 경쟁력 있는 선도적 성능을 입증했다. 과학·수학·코딩 문제 해결은 물론, 검색 도구를 활용해 다양한 분야의 전문가급 질문을 해결하는 평가 항목에서도 높은 수준의 결과를 보였다.

큐원3-맥스-씽킹의 차별화된 성능은 두 가지 핵심 기술 혁신에서 비롯된다. 첫째는 적응형 도구 활용(Adaptive Tool-use) 기능이다. 이는 모델이 상황에 따라 정보를 검색하고 내장된 코드 인터프리터를 필요 시 자동으로 호출해 활용함으로써, 사용자가 도구를 직접 선택하지 않아도 보다 효율적인 문제 해결이 가능하도록 설계됐다. 둘째는 고도화된 테스트 단계 확장(Test-time Scaling) 기법으로, 이를 통해 추론 성능을 크게 향상시키고 주요 추론 벤치마크에서 다른 고성능 모델들을 상회하는 결과를 기록했다.

기존에는 작업마다 사용자가 도구를 직접 선택해야 했던 반면 큐원3-맥스-씽킹은 대화 중 검색(Search), 메모리(Memory), 코드 인터프리터(Code Interpreter)를 동적으로 선택·활용한다. 이러한 기능은 도구 활용을 위한 초기 미세 조정(fine-tuning) 이후, 규칙 기반(rule-based) 및 모델 기반(model-based) 피드백을 결합한 다양한 과제 학습을 통해 구현됐다.

특히 검색 및 메모리 기능은 환각(Hallucination)을 줄이고 실시간 정보 접근성을 높이며, 사용자의 개인적인 필요에 맞춘 응답 생성을 가능하게 한다. 또한 코드 인터프리터는 코드 실행이나 계산 기반 추론이 필요한 복잡한 문제를 보다 효율적으로 해결할 수 있도록 지원한다.

알리바바는 여기에 더해 경험 누적형 다회차 테스트 단계 확장 전략을 도입했다. 이 방식은 이전 상호작용에서 도출된 핵심 정보를 정제·활용함으로써, 이미 알려진 결론을 반복적으로 재추론하지 않고 남아 있는 불확실성 해결에 집중하도록 설계됐다. 이를 통해 단순히 대화 기록을 그대로 참조하는 방식보다 문맥 효율을 높였다. 또 유사한 토큰 비용으로 기존 표준 방식인 병렬 샘플링 및 집계 대비 지속적으로 높은 성능을 기록했다.