2일 김성훈 업스테이지 대표는 공개 검증회를 열고 “솔라 모델은 바닥부터 직접 학습시킨 프롬 스크래치 모델”이라며 의혹을 제기한 사이오닉AI 고석현 대표 측에 공식적인 사과를 요구했다.

앞서 고석현 사이오닉AI 최고경영자(CEO)는 전날 소셜미디어(SNS)에 업스테이지의 AI 모델 솔라 오픈이 중국 기업 지푸AI(ZhipuAI)의 ‘GLM-4.5-에어’에서 파생됐다는 게시글을 올렸다.

이에 맞서 김성훈 대표는 프롬스크래치 모델임을 입증하는 데 있어 ‘가중치’의 중요성을 강조했다. 그는 “프롬 스크래치 여부를 가르는 결정적 잣대는 모델의 가중치가 랜덤하게 초기화된 상태에서 학습을 시작했느냐는 점”이라며 “남의 집 웨이트를 한 조각이라도 가져왔다면 그것은 독자 모델이 아니지만 솔라는 처음부터 우리만의 방식으로 구워낸 모델”이라고 설명했다.

그는 ‘체크포인트(Checkpoints)’와 ‘원DB(WandB)’ 로그도 공개했다. 9월 초 학습 시작 단계부터 500~5000스텝마다 기록된 학습 로그에는 로스(Loss) 값이 떨어지고 지능(MMLU 성능)이 올라가는 과정이 녹아져 있어 프롬스크래치를 입증하는 수단이 될 수 있다는 판단에서다. GPU 자원을 활용해 마지막 1분까지 학습시킨 기록이 있으며 누구든 모든 체크포인트를 점검할 수 있도록 개방하겠다는 게 김 대표의 입장이다.

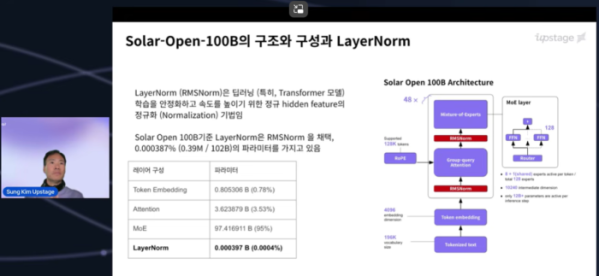

고석현 대표가 제기한 ‘레이어놈(LayerNorm) 유사성 0.989’에 대해서는 기술적 반박을 이어갔다. 김 대표는 “레이어놈은 모델 전체 파라미터 중 0.000397%에 불과한 연결고리일 뿐이며 대부분 양수 값을 가지는 특성상 코사인 유사도를 쓰면 어떤 모델과 비교해도 높게 나온다”고 반박했다.

중국 지푸AI GLM 모델과 토크나이저(사전)가 유사하다는 지적에 대해서도 정면 반박했다. 그는 “단어를 숫자로 바꾸는 사전인 토크나이저는 독립적으로 만들어도 60~70%가 겹치는 게 일반적”이라며 “솔라(196K)와 GLM(151K)의 보캡(단어) 겹침은 40% 수준에 불과하다”고 했다.

그는 이어 “표준 백과사전과 동아 백과사전의 단어가 겹친다고 해서 베꼈다고 하지 않듯, 솔라의 토크나이저는 완전히 새로 구축된 것”이라며 “오히려 유사도가 낮은 것은 우리만의 독창적인 데이터 정제 과정을 거쳤다는 증거”라고 설명했다.

중국 지푸AI 저작권 병기와 관련해서는 실무적 실수일 뿐 사안의 본질과는 무관하다고 선을 그었다. 김 대표는 “인퍼런스 코드는 모델의 가중치만 있으면 누구나 새로 짤 수 있는 그릇과 같은 것”이라며 “12월 31일이라는 국가 과제 마감 기한에 맞춰 모델 학습에 모든 GPU 역량을 쏟다 보니 편의를 위해 제공한 추론 코드 라이선스를 꼼꼼히 살피지 못했다”고 해명했다.

그러면서 “허깅페이스 생태계에서 표준화된 코드를 참고하고 수정하는 것은 오픈소스의 관행이며 이를 뒤늦게 바로잡는 과정에서 원저작자를 명시한 것일 뿐”이라며 “이것이 모델 자체가 중국산이라는 증거가 될 수는 없다”고 힘주어 말했다.

김성훈 대표는 이번 사건이 건강한 대한민국 AI 생태계의 발전을 저해할 수 있다고 우려했다. 그는 “이미 깃허브에서 리포트를 내린 것으로 아는데 그 자체가 메시지가 된다”면서 “이런 이슈가 해결하지 못했을 때 정부 심사에 상당한 영향을 끼칠 수 있다. 공개 사과를 해주시기를 부탁드린다”고 강조했다.

마지막으로 “(정부 과제 요건을) 당연히 만족하며, 정부와 전문가들이 공정하게 판단해 줄 것”이라고 했다. 업스테이지는 4일 벤치마크 등 상세한 기술 리포트를 추가로 발표하고 솔라 모델의 성능 지표를 공식 업데이트할 예정이다.

![2026 병오년 신년 운세 보는 법⋯요즘은 줄 안 섭니다! [솔드아웃]](https://img.etoday.co.kr/crop/320/200/2276384.jpg)